本文主要探討機(jī)器學(xué)習(xí)算法在使用過(guò)程中出現(xiàn)“該模型已被其他請(qǐng)求過(guò)載”的錯(cuò)誤信息,并針對(duì)性地提出解決方法。在此過(guò)程中,我們從數(shù)據(jù)處理、算法優(yōu)化、網(wǎng)絡(luò)架構(gòu)、系統(tǒng)性能這四個(gè)方面進(jìn)行深入分析,并就每個(gè)方面提出了多種解決方案,供讀者參考。

數(shù)據(jù)處理是機(jī)器學(xué)習(xí)算法的基石,在數(shù)據(jù)量大或數(shù)據(jù)質(zhì)量較低的情況下,算法的性能會(huì)直接受到影響,容易造成算法過(guò)載的錯(cuò)誤。為了解決這個(gè)問(wèn)題,我們可以從以下三個(gè)方面入手:

首先,對(duì)數(shù)據(jù)進(jìn)行預(yù)處理,包括數(shù)據(jù)去重、數(shù)據(jù)清洗、特征提取等,清洗出高質(zhì)量的數(shù)據(jù)再進(jìn)行模型訓(xùn)練和測(cè)試。

其次,多采用分布式計(jì)算的方式來(lái)進(jìn)行數(shù)據(jù)處理,可以提高數(shù)據(jù)處理的效率,從而減少算法出現(xiàn)過(guò)載的可能性。

最后,需要對(duì)數(shù)據(jù)量進(jìn)行控制,不能將所有數(shù)據(jù)一次性喂給模型,而應(yīng)該采用分批次輸入數(shù)據(jù)的方式,對(duì)模型進(jìn)行增量學(xué)習(xí)。

在機(jī)器學(xué)習(xí)中,模型的選擇和優(yōu)化也是至關(guān)重要的,雖然一些算法有可能在訓(xùn)練集上表現(xiàn)很好,但在測(cè)試集上表現(xiàn)不佳。下面,我們就從算法的選擇、優(yōu)化和評(píng)估三個(gè)方面,分別提出解決方案。

首先,關(guān)于算法選擇方面,我們需要根據(jù)數(shù)據(jù)類(lèi)型和模型任務(wù)的處理要求,選擇適合的算法。同時(shí),在算法進(jìn)行過(guò)程中,我們需要對(duì)算法進(jìn)行優(yōu)化,例如使用 L1 或 L2 正則可以對(duì)模型產(chǎn)生穩(wěn)定的結(jié)果,進(jìn)而提高算法的性能。

其次,我們需要對(duì)算法進(jìn)行評(píng)估,選擇合適的損失函數(shù)。常見(jiàn)的損失函數(shù)有平方損失、對(duì)數(shù)損失等。選取合適的損失函數(shù),能讓算法更快地進(jìn)行收斂,增加算法的運(yùn)行速度,避免模型過(guò)載。

最后,我們可以使用神經(jīng)網(wǎng)絡(luò)的方式,通過(guò)加經(jīng)過(guò)正則化(如對(duì)權(quán)重進(jìn)行懲罰)的懲罰項(xiàng)的方法,來(lái)防止過(guò)擬合。還可以通過(guò)調(diào)整模型深度、調(diào)整激活函數(shù)、調(diào)整網(wǎng)絡(luò)結(jié)構(gòu)等方式進(jìn)行算法的優(yōu)化,提高算法的魯棒性和準(zhǔn)確性。

在機(jī)器學(xué)習(xí)中,網(wǎng)絡(luò)架構(gòu)對(duì)模型的訓(xùn)練效率也有重要的影響。基本的網(wǎng)絡(luò)架構(gòu)還是常見(jiàn)的MLP(多層感知機(jī))。而在卷積網(wǎng)絡(luò)和循環(huán)網(wǎng)絡(luò)中,我們需要考慮到連接數(shù)量和層數(shù)等問(wèn)題。下面就基本網(wǎng)絡(luò)和卷積網(wǎng)絡(luò)、循環(huán)網(wǎng)絡(luò)進(jìn)行優(yōu)化提出以下幾點(diǎn)思路:

首先,對(duì)于基本的網(wǎng)絡(luò)架構(gòu),我們需要關(guān)注價(jià)格、速度和精度三個(gè)方面,同時(shí)權(quán)衡設(shè)計(jì)的規(guī)范性和合理性。

其次,對(duì)于卷積神經(jīng)網(wǎng)絡(luò)和循環(huán)神經(jīng)網(wǎng)絡(luò),我們也需要對(duì)網(wǎng)絡(luò)架構(gòu)進(jìn)行優(yōu)化,可以根據(jù)架構(gòu)性能差異來(lái)選擇,還可以通過(guò)深度可分卷積、殘差網(wǎng)絡(luò)和注意力機(jī)制等手段進(jìn)行優(yōu)化。

最后,我們可以使用蒸餾技術(shù),通過(guò)產(chǎn)生更小的神經(jīng)網(wǎng)絡(luò)模型模仿更大的模型,來(lái)減少計(jì)算量和通信量,從而提高網(wǎng)絡(luò)訪問(wèn)速度。

除了以上幾個(gè)方面之外,機(jī)器學(xué)習(xí)算法的運(yùn)行環(huán)境還影響算法的性能。系統(tǒng)性能包括帶寬、內(nèi)存或磁盤(pán)I/O等,也是造成“該模型已被其他請(qǐng)求過(guò)載”的主要原因之一。以下是針對(duì)系統(tǒng)性能優(yōu)化的思路。

首先,我們可以增加硬件設(shè)備的性能,例如加速器、分布式計(jì)算等,提高計(jì)算的效率,減少 CPU 或 GPU 的壓力,提高算法訪問(wèn)速度。

其次,我們可以?xún)?yōu)化系統(tǒng)配置,例如調(diào)整虛擬內(nèi)存、調(diào)整硬盤(pán) I/O 等以提高系統(tǒng)的性能。

最后,我們還可以考慮是否使用 CDN(內(nèi)容分發(fā)網(wǎng)絡(luò))來(lái)分發(fā)數(shù)據(jù)模型,還可以使用緩存數(shù)據(jù)和負(fù)載均衡技術(shù)來(lái)減少服務(wù)器負(fù)載,從而解決出現(xiàn)過(guò)載的問(wèn)題。

總結(jié):

綜上所述,算法過(guò)載是機(jī)器學(xué)習(xí)的常見(jiàn)現(xiàn)象之一,在數(shù)據(jù)處理、算法優(yōu)化、網(wǎng)絡(luò)架構(gòu)、系統(tǒng)性能等多個(gè)方面都有著千絲萬(wàn)縷的聯(lián)系。不同的應(yīng)用場(chǎng)景和需求,需要針對(duì)性地采用不同的優(yōu)化方法,以期提高模型的準(zhǔn)確性和穩(wěn)定性,避免出現(xiàn)過(guò)載的情況。

當(dāng)出現(xiàn)過(guò)載時(shí),我們可以根據(jù)提示信息,重試請(qǐng)求,或者通過(guò)我們的幫助中心提出申訴,以便更快更好地解決問(wèn)題。

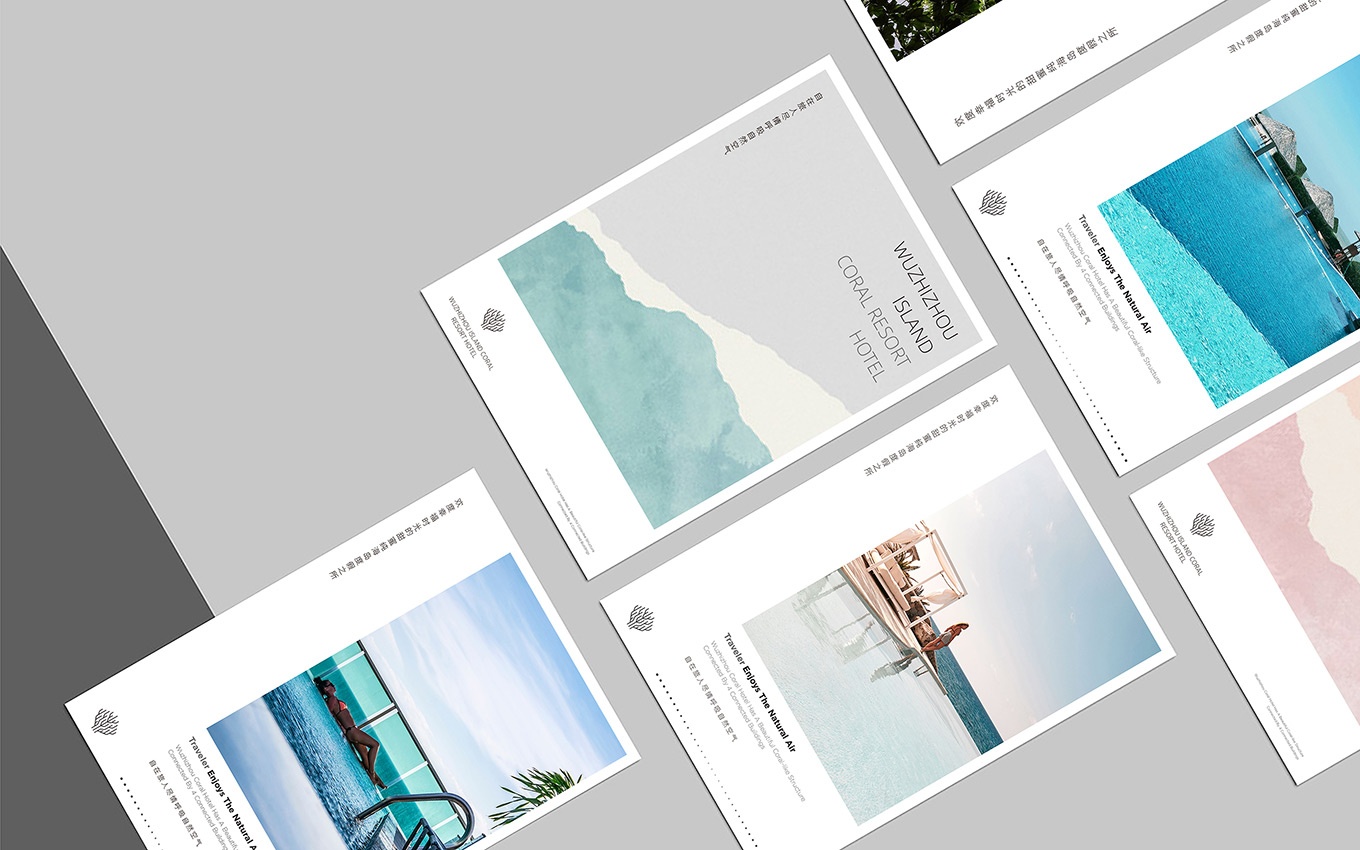

上文工作室vi設(shè)計(jì)介紹很精彩,接下來(lái)我們一起欣賞北京vi設(shè)計(jì)公司部分案例:

工作室vi設(shè)計(jì)配圖為北京vi設(shè)計(jì)公司作品

工作室vi設(shè)計(jì)配圖為北京vi設(shè)計(jì)公司作品

本文關(guān)鍵詞:工作室vi設(shè)計(jì)

Copyright 2005-2024 ? UCI All Rights Reserved

聯(lián)合創(chuàng)智北京vi設(shè)計(jì)公司 版權(quán)所有

總監(jiān)微信咨詢(xún) 舒先生

業(yè)務(wù)咨詢(xún) 舒先生

業(yè)務(wù)咨詢(xún) 付小姐